由于之前实验创建了很多RBD存储池以及对应的镜像,并且在cephfs也有很多垃圾数据,后面不需要使用了,所以我这边介绍下如何删除RBD、CephFS、以及Pool存储池

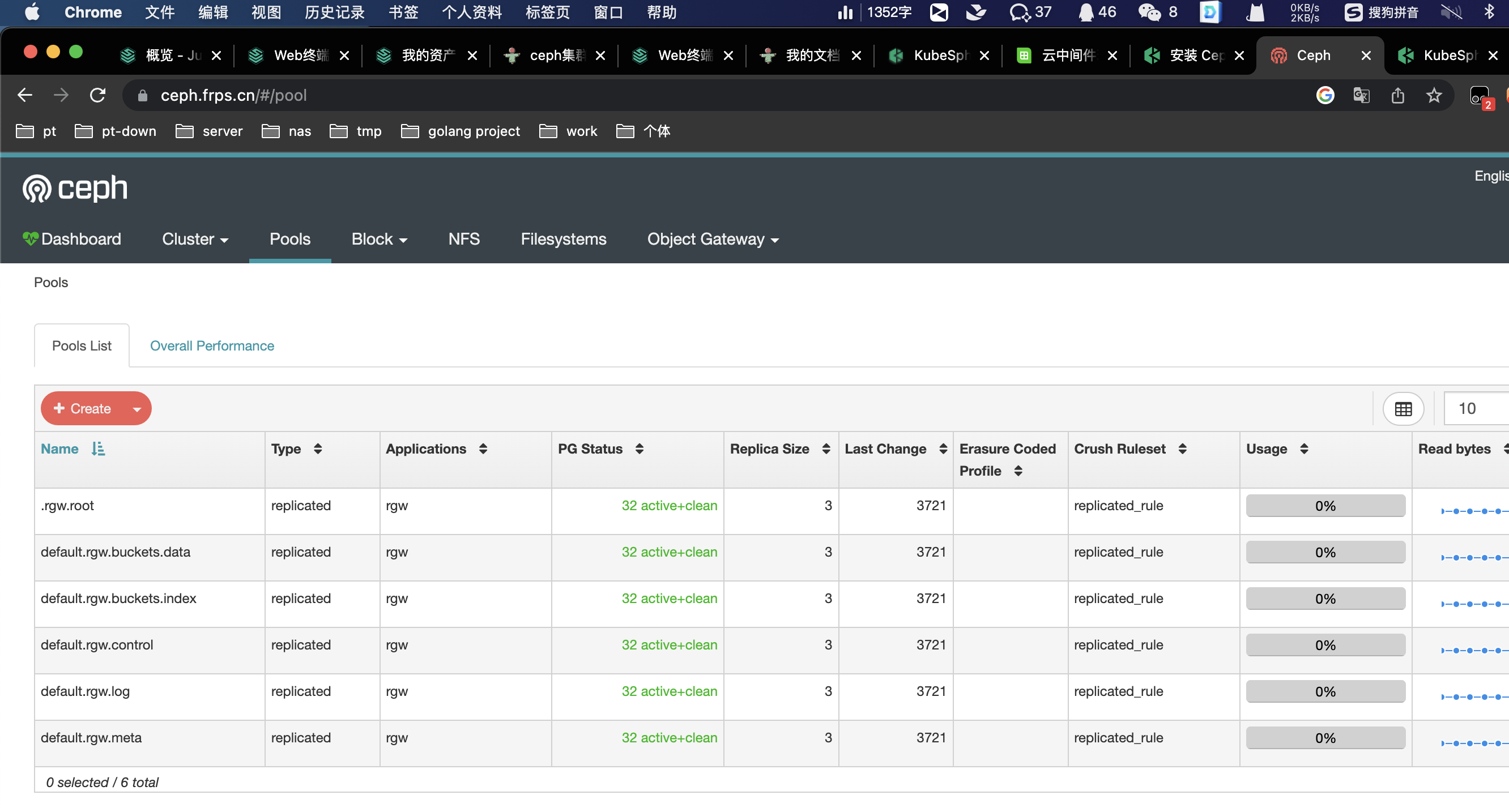

[root@ceph-01 ~]# ceph osd pool ls

.rgw.root

default.rgw.control

default.rgw.meta

default.rgw.log

default.rgw.buckets.index

default.rgw.buckets.data

#以上为Ceph内置存储池,我这边不管它

#下面的存储池就是我们要删除的

abcdocker

cephfs_data

cephfs_metadata

kubernetes

fs_data

fs_metadata

kube

abcdocker_rbd

abcdocker_data

cephfs-data

cephfs-metadata

i4t_data

i4t_metadata删除RBD

在删除存储池之前,我们需要手动先删除RBD的镜像。一般我们创建Pool存储池的时候就已经命名了

#查看RBD

[root@ceph-01 ~]# rbd ls kubernetes

csi-vol-18bb0c5b-e286-11ec-a7ae-7e84c5effa12

csi-vol-1f7f5694-e286-11ec-a7ae-7e84c5effa12

csi-vol-2d721d5f-e286-11ec-a7ae-7e84c5effa12

csi-vol-3be06d4e-e27f-11ec-a7ae-7e84c5effa12删除RBD

rbd rm kubernetes/csi-vol-1f7f5694-e286-11ec-a7ae-7e84c5effa12

rbd rm kubernetes/csi-vol-3be06d4e-e27f-11ec-a7ae-7e84c5effa12

rbd rm kubernetes/csi-vol-6b8cd42c-e281-11ec-a7ae-7e84c5effa12

rbd rm kubernetes/csi-vol-8cf2bc82-f483-11ec-a2b1-9af24b413276

#kubernetes为Pool池名称

#csi-vol.xxx为RBD名称当Pool池中没有rbd文件后,就可以通过下面的方式进行删除Pool池

ceph osd pool rm kubernetes kubernetes --yes-i-really-really-mean-it

#kubernetes为Pool池名称,需要输入2次

# --yes-i-really-really-mean-it 确认删除删除cephfs

cephfs肯定就不可以像rbd那样删除

首先先查看一下ceph fs信息

ceph fs ls将ceph fs 标记下线

ceph fs fail cephfs-abcdocker删除ceph fs

ceph fs rm cephfs-abcdocker --yes-i-really-mean-it在删除对应的Pool池

ceph osd pool rm cephfs-abcdocker cephfs-abcdocker --yes-i-really-really-mean-it 清理完成

[root@ceph-01 ~]# ceph -s

cluster:

id: c8ae7537-8693-40df-8943-733f82049642

health: HEALTH_OK

services:

mon: 3 daemons, quorum ceph-01,ceph-02,ceph-03 (age 89m)

mgr: ceph-01(active, since 46h), standbys: ceph-02, ceph-03

mds: 3 up:standby

osd: 5 osds: 5 up (since 87m), 5 in (since 11d)

rgw: 2 daemons active (ceph-01, ceph-02)

task status:

data:

pools: 6 pools, 192 pgs

objects: 228 objects, 2.5 KiB

usage: 5.5 GiB used, 275 GiB / 280 GiB avail

pgs: 192 active+clean

[root@ceph-01 ~]# ceph osd pool ls

.rgw.root

default.rgw.control

default.rgw.meta

default.rgw.log

default.rgw.buckets.index

default.rgw.buckets.data

[root@ceph-01 ~]# ceph fs ls

No filesystems enabled在ui中也看不到了